OpenAI представила нейросеть DALL-E, которая создаёт изображения по запросу. Это важный шаг к более осмысленному ИИ

Исследователи из OpenAI представили две новые нейросети — DALL-E и CLIP. Первая создает иллюстрации, фотографии и рендеры на основе простого описания. Например, она может изобразить «кота в галстуке-бабочке» или «дайкона в пачке, выгуливающего собаку». Вторая определяет объекты и классифицирует их, основываясь на простом описании.

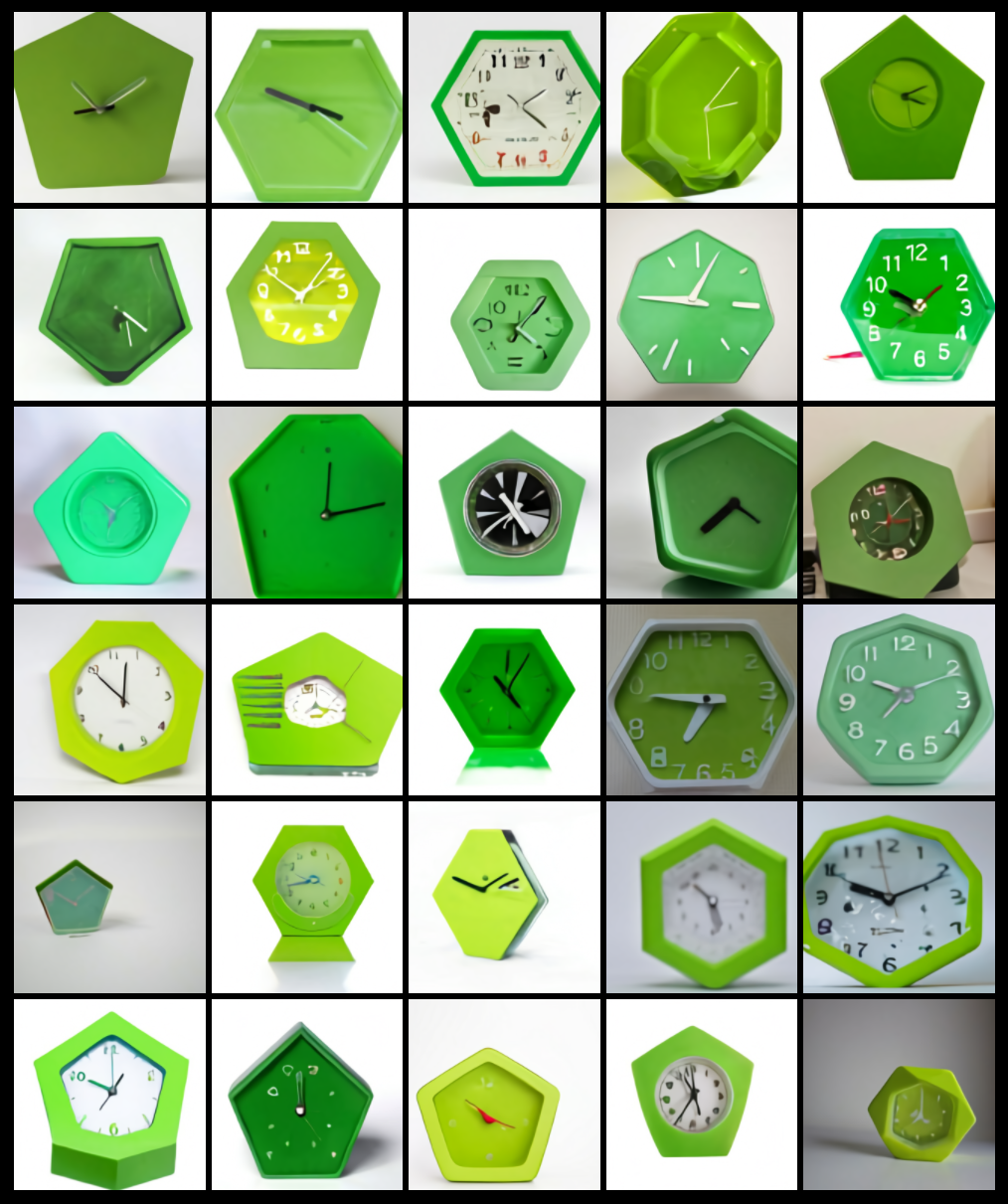

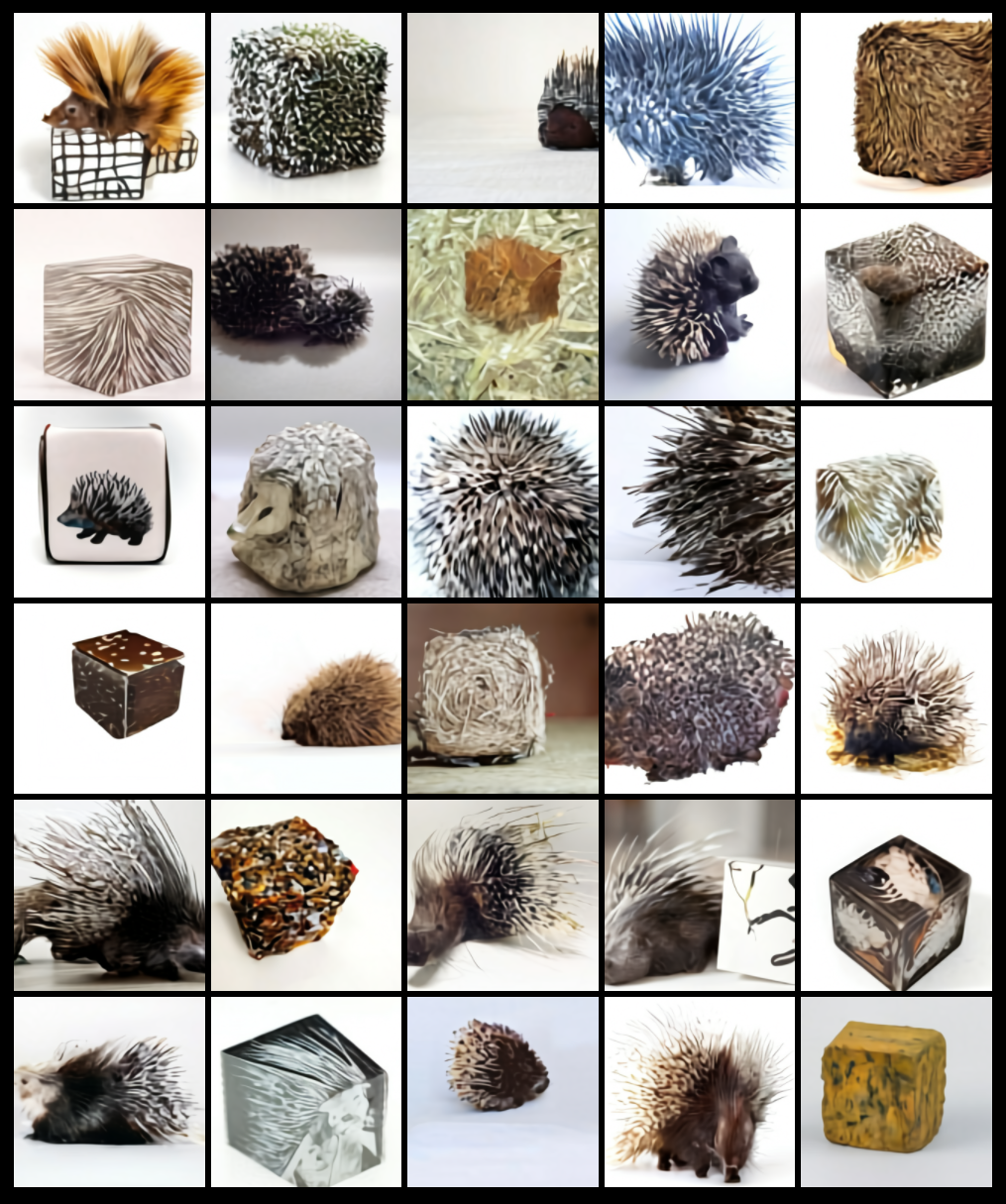

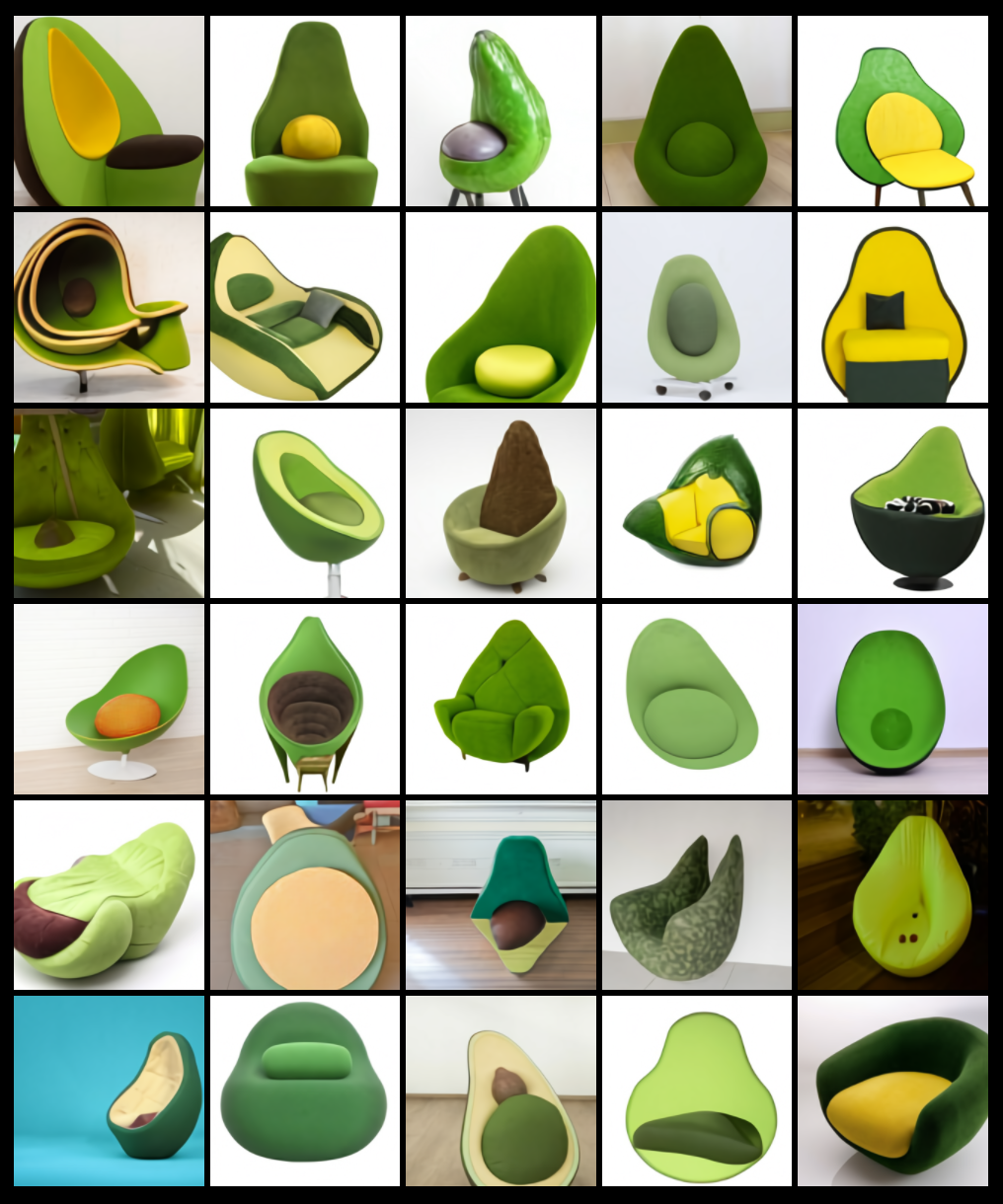

Нейросеть DALL-E создаёт изображения из текста. Она не находит их в открытых источниках, а генерирует самостоятельно. Например, она может создать коллекцию картинок по запросу «пятиугольные зелёные часы» или «куб с текстурой дикобраза».

Также нейросеть может создавать изображения одежды, интерьера, мебели, еды, животных. Теоретически, DALL-E умеет генерировать образ человека, однако в коллекции примеров на сайте OpenAI такой вариант не представлен.

Нейросеть DALL-E обрабатывает естественный язык (английский) и простые запросы на нём.

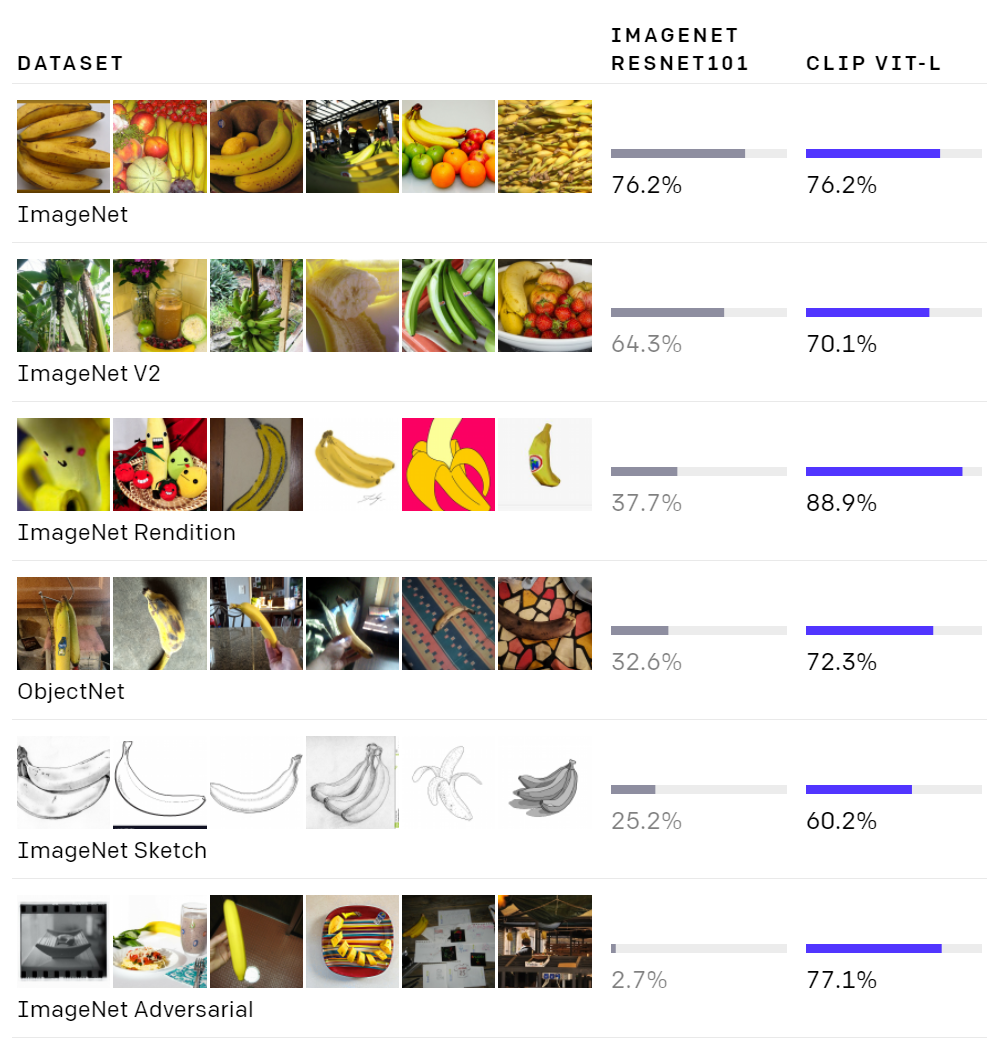

Вторая разработка OpenAI — нейросеть CLIP. Она способна классифицировать изображения по описанию на английском языке. При этом обучение ИИ происходит на основе нулевых данных.

CLIP умеет распознавать изображения без примеров в тщательно отобранных наборах данных, как это делают большинство существующих моделей. Она узнает, что показано на изображении, по всему описанию, а не по тегу из одного слова, например «кошка» или «банан».

«Это сказочно интересная и мощная работа, и, как и другие проекты OpenAI, она, несомненно, вскоре перерастёт во что-то еще более сказочное и интересное», — отмечает Tech Crunch. Однако будущее технологии пока трудно представить.

В OpenAI продолжают работать над обеими нейросетями. Причём речь идёт не только о технической, но и об этической стороне результатов, которые генерируют DALL-E и CLIP.

«Мы живём в визуальном мире», — говорит Илья Суцкевер, один из руководителей OpenAI. «В конечном итоге мы получим модели, которые понимают и текст, и изображения. ИИ будет лучше понимать язык, потому что он сможет видеть, что означают слова».