ИИ научился предсказывать правила игры, зная только последовательности ходов

Исследователи из Копенгагенского университета представили новые доказательства в поддержку «гипотезы модели мира Отелло». Эта гипотеза предполагает, что большие языковые модели (LLM) способны формировать внутреннее представление о правилах и структуре игры, анализируя только последовательности ходов. При этом модели никогда не видят ни правил, ни визуального изображения игрового поля.

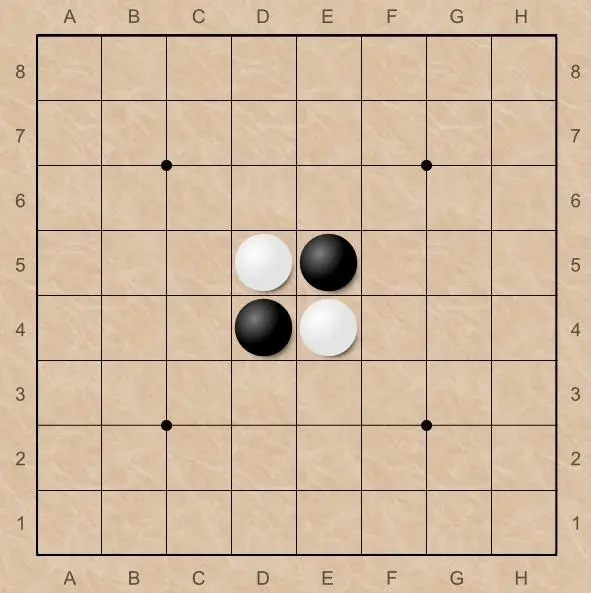

Суть проблемы, которую затрагивает исследование, — это понимание того, на что на самом деле способны современные LLM. Критики часто утверждают, что это просто «стохастические попугаи», слепо имитирующие шаблоны в данных. Эксперимент с игрой Отелло (другое название Реверси) был призван проверить, могут ли модели абстрагироваться от текстовых данных и построить внутреннюю модель пространственной задачи, какой является настольная игра.

В ходе нового исследования ученые обучили семь различных языковых моделей, включая GPT-2, LLaMA-2 и Qwen2.5, предсказывать следующий ход в игре Отелло. Они использовали как реальные, так и синтетические наборы данных с миллионами игр. Ключевым отличием от предыдущих работ стало использование инструментов «выравнивания представлений», которые позволили напрямую сравнить внутренние «карты» игрового поля, созданные каждой моделью.

Результаты оказались впечатляющими. Все модели не только научились играть в Отелло с высокой точностью (уровень ошибок менее 6% на реальных данных и менее 0,1% на синтетических), но и выработали поразительно схожие внутренние представления пространственной структуры доски. Это доказывает, что модели действительно понимают игру, а не просто угадывают ходы. Причем предварительное обучение на общих текстах не давало значительного преимущества.

Эти выводы имеют большое значение для исследований ИИ. Они бросают вызов представлению о том, что системы, обученные только на одном типе данных (например, тексте), не могут решать задачи, требующие понимания визуальной или пространственной информации. Результаты также дают новое понимание проблемы «заземления символов» — как абстрактные символы (например, «C3» в Отелло) связываются с реальным значением. Исследование показывает, что LLM способны на более глубокий уровень абстракции, чем считалось ранее.