Карты, деньги и дипфейки: как мошенники используют технологии для вымогательств

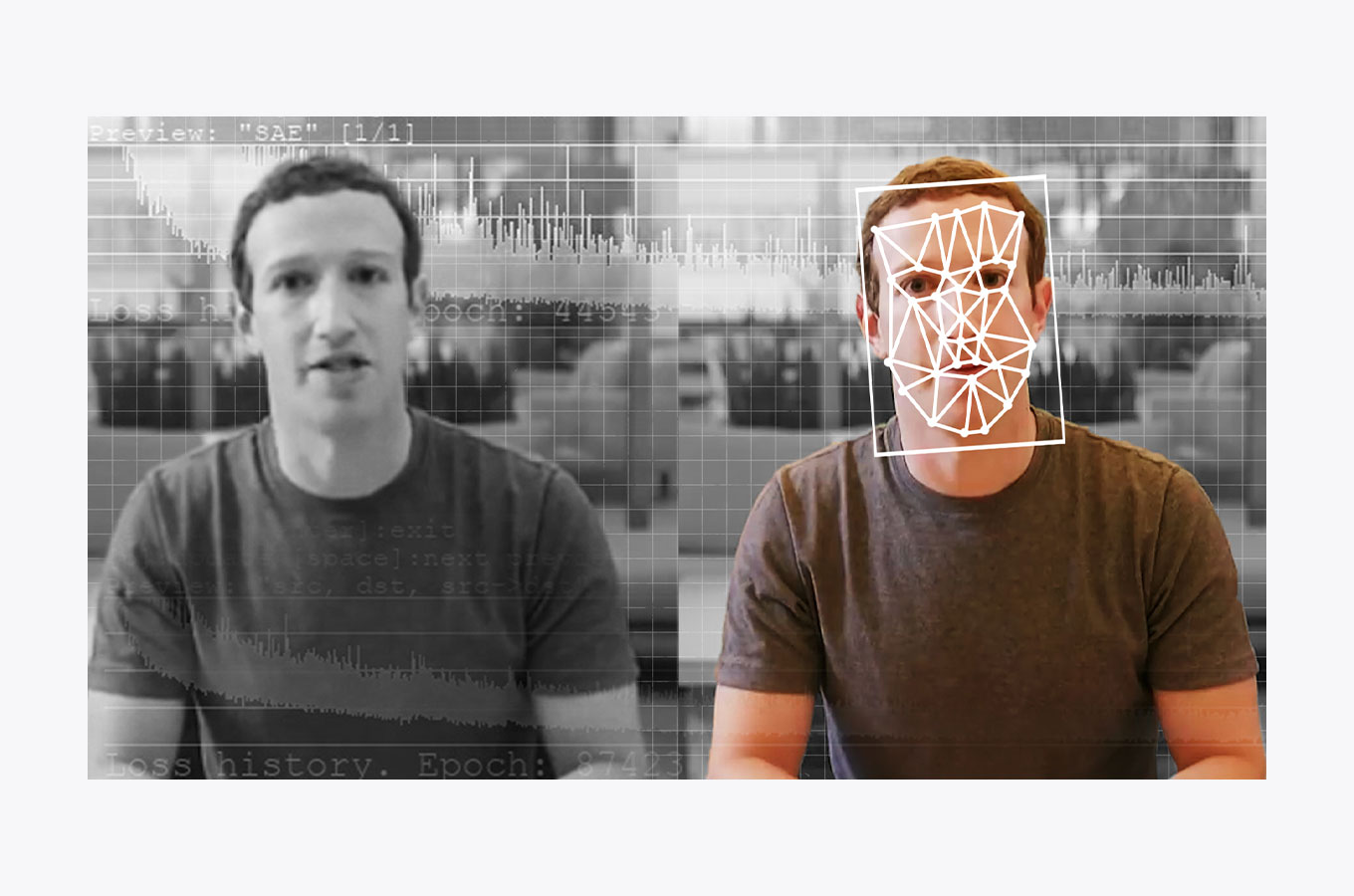

Может ли Илон Маск петь «Траву у дома», Том Круз — показывать фокусы в TikTok, а Бред Питт — стать Терминатором? В дипфейках — да. Термин deepfake произошел от двух слов: «глубокий» и «фальшивый». Под глубиной в этом случае подразумевается разновидность машинного обучения — глубокое обучение. С помощью нейросетей сегодня можно генерировать изображения и видеоролики с несуществующими людьми, заменять лица и подделывать голоса.

Дипфейки уже используются в рекламе, моде, журналистике и обучении. Однако больше 90% подделок созданы, чтобы навредить репутации, — например с помощью порнографических роликов.

Цифры и факты

Количество дипфейков в мире растет экспоненциально: в декабре 2018 года в сети можно было найти около 8 тыс. поддельных видео, в декабре 2019 года — уже больше 24 тыс., в прошлом году — 85 тыс. Такие данные приводит в своем исследовании Sensity. По словам их СЕО, только 7% дипфейков созданы в качестве развлечения, а все остальные используются, чтобы навредить чьей-либо репутации.

В 2019 году Forrester прогнозировал, что общие денежные потери бизнеса из-за дипфейков достигнут $250 млн в 2020 году. Точно неизвестно, сбылся ли этот прогноз, однако количество мошеннических операций с синтезированными подделками растет — в том числе в России.

Дипфейки как инструмент для мошенничества

Инвестиционное вымогательство

Распространенный вариант мошенничества — фальсификация видеозаписей и вымогательство. В начале сентября в сети появилось deepfake-видео с Олегом Тиньковым, в котором поддельный бизнесмен обещал бонус 50% к сумме вложений в «Тинькофф Инвестиции». При переходе по ссылке рядом с видео пользователь попадал на лендинг с логотипом банка и инвестиционного сервиса. Ему предлагали ответить на несколько общих вопросов и оставить имя, телефон и email. Сгенерированное видео было не самого хорошего качества: движения губ и речь рассинхронизированы, голос не похож на оригинал. Но этого хватит, чтобы обмануть пользователей, которые пролистывают ленту в соцсетях со смартфона, — а потом получить их данные и деньги.

Похожая история произошла с CEO DBrain Дмитрием Мацкевичем. В январе в сети появилось два мошеннических видео: в одном предприниматель рассказывал про работу трейдеров и финансовые модели DBrain, в другом — приглашал на мастер-класс о том, как получать доход от 30% в месяц при минимальных инвестициях. В записях фигурировал адрес поддельного сайта, который мимикрировал под настоящий, на нем предлагали оставить почту и номер телефона для регистрации на мастер-класс. На сайте злоумышленников также можно было увидеть логотип Barclay Stone — «типичного псевдоброкера без лицензии», как их называет «Вкладер». Скорее всего, реальной целью мошенников было заманить людей к брокеру.

Порнографический шантаж

Значительная часть дипфейков — порнография. Жертвами регулярно становятся знаменитости. Например, в числе жертв злоумышленников — Натали Портман, Тейлор Свифт, Галь Гадот и другие. Но подделывают внешность и голос не только известных людей.

В 2021 году в Индии стали все чаще происходить случаи мошенничества с использованием видеозвонков, в процессе которых женщина раздевается на камеру и побуждает мужчину делать то же самое. Жертву записывают на видео и потом шантажируют, вымогая до 2 млн рупий. Полиция города Ахмедабад обнаружила, что в 60% случаев жертвы говорили не с реальными женщинами, а с дипфейками. Мошенники используют программы, которые переводят текст в аудио и, предположительно, видео с порносайтов.

Фальшивые звонки

Вымогать деньги можно не только с помощью видеороликов: в 2019 году в Великобритании зафиксировали первый случай мошенничества с помощью дипфейк-аудио. CEO британской энергетической компании подумал, что разговаривает по телефону с директором материнской компании из Германии. Подделанный с помощью нейросетей голос попросил его в течение часа перевести €220 тыс. на счет венгерского поставщика.

Похожий случай произошел в 2020 году: сотрудник технологической фирмы получил голосовое сообщение от «СЕО», который просил помочь ему со срочной бизнес-сделкой. Правда, голос звучал довольно механически, так что работник заподозрил неладное и отправил войс в юридический департамент.

Политические махинации

Частое опасение, связанное с дипфейками, — что они будут использоваться в политических целях. Такие примеры уже есть, и речь не про знаменитый дипфейк Обамы, в котором он обзывает Трампа. В феврале 2020 года, за день до выборов в Законодательное собрание в Нью-Дели, дипфейк-видео главы одной из ведущих общенациональных партий Индии стали вирусными в WhatsApp. В одном из них он говорил на диалекте хинди, хариани. Это видео использовалось, чтобы отговорить рабочих-мигрантов голосовать за другую партию. Дипфейки распространили в 5,8 тыс. групп WhatsApp в Дели и Национальном столичном регионе, охватив примерно 15 млн человек.

Другой интересный пример: видео с экс-премьер-министром Бельгии Софи Вильмес, которое опубликовала организация Extinction Rebellion Belgium. Этот дипфейк — модификация предыдущего обращения к нации по поводу пандемии. В вымышленной речи говорится, что последние глобальные эпидемии напрямую связаны с «эксплуатацией и разрушением людьми природной среды». Для воспроизведения голоса и манеры речи использовался ИИ.

И другие кейсы

Возможности для мошенничества с помощью дипфейков этим не ограничиваются. С их помощью можно, например, обойти систему распознавания лиц вроде Face ID и получить доступ к личным данным пользователей. Бывают и более масштабные операции: в январе Народная прокуратура Шанхая арестовала двух жителей Китая — они покупали фотографии людей, «оживляли» их с помощью приложений и проходили систему проверки личности налоговой службы. Преступники зарегистрировали компанию и выдавали своим клиентам поддельные накладные. За два года они заработали на этом $76,2 млн.

Можно ли отличить дипфейк от реальности?

Да, но это сложно. Противодействие дипфейкам — игра в кошки-мышки, так как мошенники тоже совершенствуют технологию. Например, в 2018 году выяснилось, что люди в дипфейках не моргают или делают это странно. Особенность сразу же учли в усовершенствованных моделях.

Чтобы стимулировать создание технологий для обнаружения дипфейков, Facebook и Microsoft проводят Deepfake Detection Challenge. В 2020 году в нем приняли участие более 2 тыс. человек. Разработчикам удалось добиться точности распознавания более 82% на стандартном тестовом датасете, но на усложненном (с отвлекающими компонентами вроде надписей) она упала чуть более чем до 65%.

ПО для обнаружения дипфейков можно обмануть, слегка видоизменяя входные данные, так что исследователи продолжают вести работу в этой области. В июне 2021 года ученые из Facebook и Университета штата Мичиган объявили о новой разработке. Обычно детекторы определяют, какая из известных моделей ИИ сгенерировала дипфейк. Новое решение лучше подойдет для практического применения: оно может распознавать подделки, созданные с помощью методов, с которыми алгоритм не сталкивался при обучении.

Еще один способ: поиск цифровых артефактов. У людей в дипфейках могут не совпадать цвета левого и правого глаза, расстояние от центра глаза до края радужной оболочки, отражение в глазах. Встречаются плохо прорисованные зубы и нереалистично темные границы носа и лица. Но в современных подделках увидеть такие артефакты может только машина. Так что самое важное в борьбе с дипфейками — быть настороже и обращать внимание на фото, видео и аудио, которые кажутся подозрительными.

Дипфейк как товар

Доступность датасетов и предобученных нейросетевых моделей, снижение стоимости вычислений и соревнование между создателями и детекторами дипфейков подгоняет рынок. Deepfake-инструменты коммодифицируются: в сети свободно распространяются программы и учебные материалы для создания подделок. Существуют простые приложения для смартфонов, которые вообще не требуют технических навыков.

Повышенный спрос на дипфейки привел к созданию компаний, которые предлагают их как продукт или услугу. Это, например, Synthesia и Rephrase.ai. В Ernst & Young дипфейки, сделанные с помощью Synthesia, уже начали использовать в клиентских презентациях и в переписке. Стартап Sonantic специализируется на озвучке видеоигр и предлагает платформу no-code для генерации голосовых клонов, а Veritone позволяет инфлюенсерам продавать лицензии на голосовые дипфейки и получать рекламные гонорары, не посещая студию.

Будущее синтетических медиа

Вместе с рынком коммерческого применения дипфейков будет расти и число мошеннических операций. В сети уже есть маркетплейсы, где публикуют запросы на подделки, например порноролики с актрисами. А некоторые алгоритмы могут сгенерировать deepfake-видео на основе одного изображения или воссоздать голос человека, используя аудио длиной в несколько секунд. Из-за этого жертвой аферистов может стать практически любой пользователь интернета.

С дипфейками борются не только с помощью технологий, но и на законодательном уровне. В США и Китае появляются законы, регулирующие их использование, а в России борьбу с ними в июле 2021 года включили в одну из дорожных карт «Цифровой экономики». Регулирование в этой области будет только усиливаться.

По данным Deeptrace, в 2019 году из почти 15 тыс. дипфейк-видео порнографическими были 96%.

На момент публикации, 1 индийская рупия соответствует 0,95 рубля.